Mi profesor será (quizás) una Inteligencia Artificial

25 junio, 2018

Una distinción importante en el campo de la Inteligencia Artificial (IA) se encuentra entre narrow AI y general AI (Artificial General Intelligence o AGI). La primera consiste en un programa informático que usa técnicas de IA (Machine Learning, Deep Learning) y está diseñado para solucionar un problema específico (desde jugar al ajedrez a detectar peatones y obstáculos por la calle). Por el contrario, la AGI se refiere a las máquinas con capacidad de resolver muchos tipos de problemas por sí solas tal como hacen los humanos, es decir, podrían entender el entorno y razonar como un ser humano. Pues bien, hasta ahora, todas las aplicaciones que hay de IA son ejemplos de narrow AI.

Aunque el IA general es actualmente un tema de investigación, aún es probable que tarde unas décadas en ser algo real (hay que pensar, sin embargo, que ya llevamos 60 años diciendo que será durante los próximos 20). De momento, sólo encontramos AGI en la literatura y las películas de ciencia ficción. Sin embargo, en los últimos años se están produciendo avances muy importantes en las técnicas de IA que permiten empezar a pensar en una AGI viable, ahora quizás sí, en, pongamos, un par de décadas.

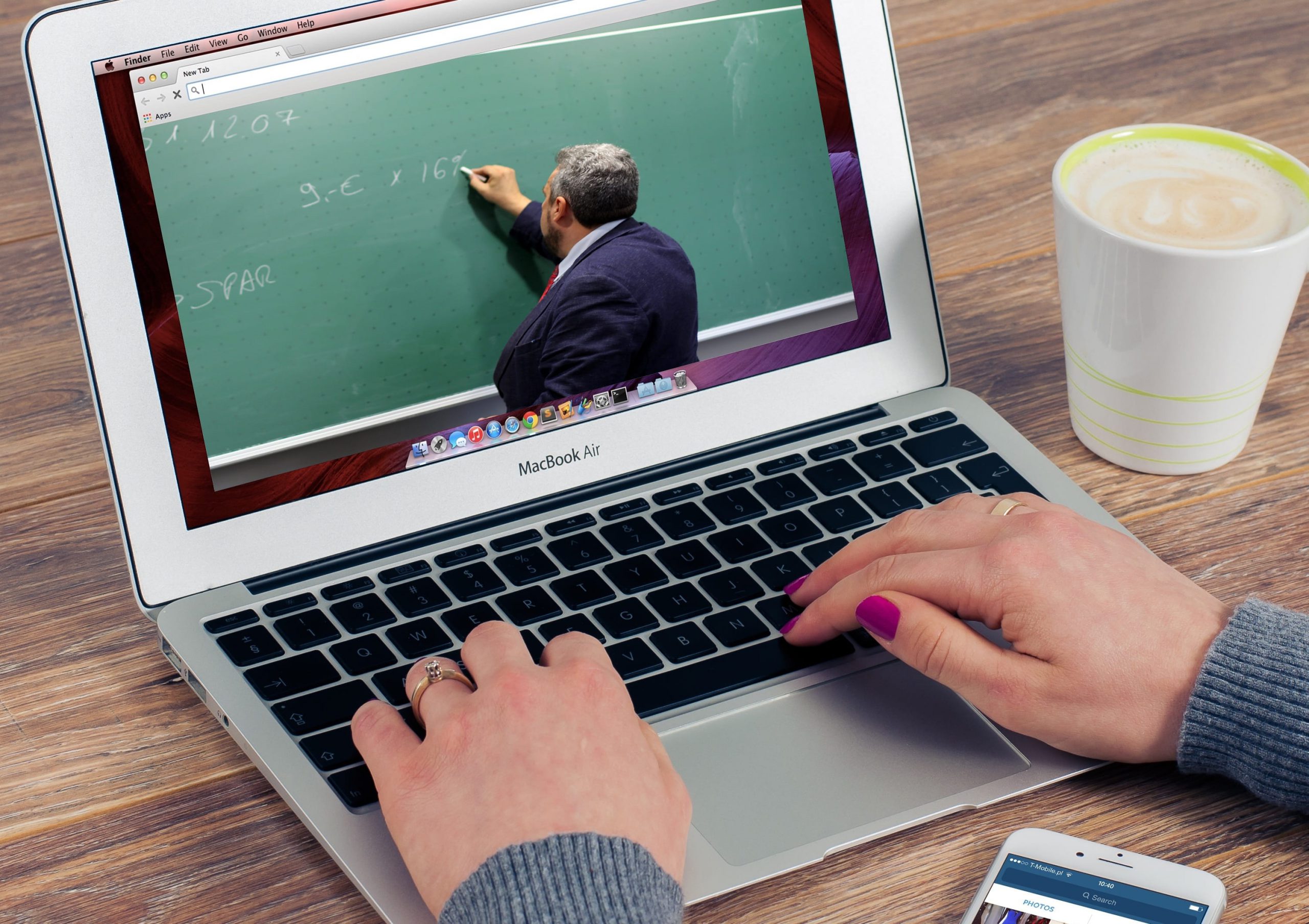

¿Y si ésta AGI la aplicáramos a la educación? ¿Cómo debería ser un bot / asistente o AGI dedicado al aprendizaje? Partiendo de lo que ya se puede hacer ahora (con chatbots y Machine Learning) y mientras hacemos este camino, nos vamos a encontrar muchas preguntas sobre la AGI que habrá que responder a medida que vayamos incorporando avances en nuestro modelo. ¿Quién sabe? quizás en 20 años nuestro profesor será una AI…

Consideraciones sobre el aspecto, la personalidad y las atribuciones docentes

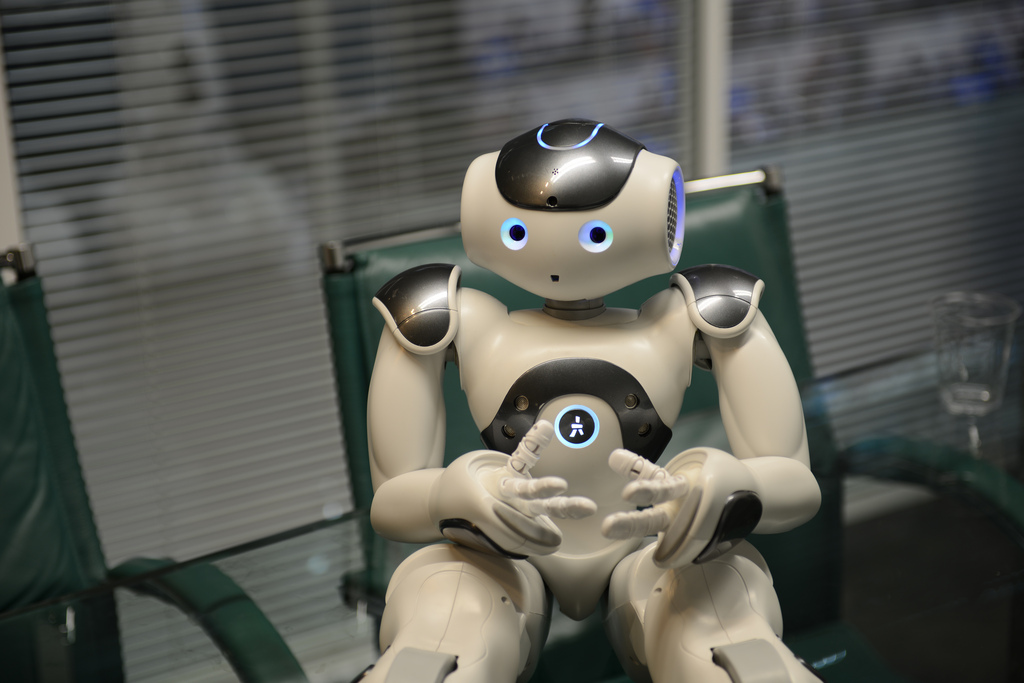

Será muy importante decidir qué grado de antropomorfismo (tendencia a considerar realidades o elementos no humanos como si fueran humanos) queremos para nuestro asistente docente. Esto implica darle o no cualidades y características humanas como puede ser ponerle nombre, decidir el aspecto que tendrá en diferentes canales (aspecto visual pero también la voz o el acento, si habla), si tiene una apariencia física (robótica) o sólo virtual y si hay que darle una historia previa. De hecho, el antropomorfismo probablemente facilitaría la comunicación y la ergonomía. También hay que pensar si habrá un solo asistente para todos o un particular para cada alumno, o uno común para cada materia.

Puede parecer banal, pero ya nos dirigimos por el nombre a Siri o Alexa. De momento no lo hacemos (quizá alguien sí) en el sistema de navegación del coche, pero la frontera no está clara. Cuando este asistente se convierta en nuestro interlocutor y deje de ser una simple herramienta, habrá que plantearse estas cosas.

Será interesante el debate sobre qué nivel de «humanidad» le debemos dar y qué relación establecerá con el alumno. Podremos simular muchas características humanas de la personalidad pero habrá que ver si lo hacemos o no, entre ellas, simular el sentido del humor, la sensibilidad, la empatía, la asertividad. También se podrá detectar el estado de ánimo del alumno y actuar en consecuencia. A parte de esto, también hay que pensar en si tendrá conciencia temporal de las sesiones anteriores.

También me pregunto si nuestro profesor virtual se limitará a responder las dudas (y será una herramienta) o será proactivo y dará consejos de cómo hacer los trabajos, recordará fechas de entrega y velará por el éxito del estudiante, ¿será como un «coach» docente? Tal vez sea necesario poner límites a la ayuda que proporciona para evitar que el estudiante se apoye demasiado en él… Ah, y todo ello, ¿será configurable? Algunos alumnos pueden sentirse mejor con un profesor virtual con una personalidad determinada o que utiliza un tono determinado.

Y, por último, respecto al nivel de «sabiduría» del bot, ¿sobre qué temáticas tendrá conocimientos? ¿sólo sobre las del temario oficial de la universidad o estará abierto a recursos externos (como Wikipedia u otras fuentes de Internet)?

Consideraciones éticas

Consideración 1. Honestidad y transparencia.

¿Es justo intentar engañar a los estudiantes y no decirles que el profesor asistente es una IA, como Jill Watson, el conocido caso de Georgia Tech o como el reciente ejemplo de Google Duplex, donde la peluquería o el restaurante, supuestamente,no saben que el cliente es una máquina? ¿o es preferible decir claramente que hay un tándem humano-máquina? Creo que la segunda opción es mejor y más justa.

Consideración 2. El antropomorfismo extremo y la «Valle inquietante»

Ligado a la consideración anterior, hay un tema a tener en cuenta. El uncanny valley,traducido como valle inquietante o valle inexplicable,es una hipótesis de la robótica que dice que cuando la apariencia de un robot es humana, la respuesta emocional de los humanos al robot se irá haciendo cada vez más positiva y empática hasta llegar a un punto a partir del cual la respuesta se vuelve en repugnancia. Después, si conseguimos que la apariencia sea aún más alta, volvemos a niveles altos de empatía. Es decir, debemos humanizar al robot pero sólo hasta cierto punto, evitando que dé miedo o angustia, o, por el contrario, decidir hacerlo virtualmente indistinguible de un humano.

Consideración 3. Sesgo debido a un entrenamiento erróneo de las máquinas

Las respuestas docentes de la IA pueden ser incorrectas porque la hayamos entrenado con datos que pueden ser erróneos como por ejemplo respuestas previas dadas por otros estudiantes (en los debates), interacciones previas con el estudiante o material no validado de Internet. Estoy convencido de que el experto humano debe estar presente de alguna manera en este proceso para validar los datos de entrenamiento. Debemos poner un «humano en el circuito” (del inglés Human-In-The-Loop, concepto también conocido por las siglas HITL) para garantizar que no hay sesgo y que no pase como con Tay, el chatbot de Microsoft que se volvió racista.

Consideración 4. El objetivo final de la máquina

Como ocurre con los automóviles autónomos (que en un hipotético caso de accidente, podrían decidir quién muere y quién no), los objetivos finales (programados) de la IA educativa podrían ser variados y incluso contradictorios:

- El objetivo podría ser que el estudiante aprenda (y entonces corremos el riesgo de que la AI ponga actividades difíciles y muy retadoras que, por otra parte, podrían causar que el estudiante suspenda).

- O podría ser que el estudiante apruebe (y luego existe el peligro de que la IA haga pruebas demasiado fáciles, sugiera las respuestas y haga que pasar el curso sea demasiado fácil y que el estudiante no aprenda).

- Incluso el objetivo podría ser que el estudiante matricule muchas asignaturas (y entonces tal vez la IA no dé información realista de la capacidad del alumno de hacer muchas asignaturas y oculte potenciales dificultades para pasar curso).

Vemos que cada parte interesada en el proceso docente (docentes, estudiantes, marketing, departamentos financieros, sociedad, mercado laboral, etc.) puede tener objetivos opuestos. En este caso, hay que poner la «sociedad en el circuito«, y hacer un contrato social educativo.

Conclusión

Quizás debemos esperar un poco para que sea posible tener un asistente artificial con todas sus funciones desplegadas pero, mientras tanto, vemos que vale la pena empezar a plantearse todas estas preguntas; algunas de las respuestas ya pueden ser implementadas hoy con el estado actual de la tecnología.

Y, con la mirada puesta en el horizonte de los 20 años, también tenemos que empezar a pensar, como sociedad, qué papel jugará la IA en la educación, las implicaciones que conllevará una AGI, cuál es el rol que deben tener las personas, cuál el de la sociedad y hacia dónde queremos ir.

*(Créditos de la foto de cabecera: Nao Robot per steveonjava en Flickr)